Google presenteerde gisteren een prototype van een zelfrijdende auto — een voertuig zonder stuur of pedalen. Volgens het bedrijf ligt de focus op veiligheid. Wereldwijd sterven jaarlijks 1,2 miljoen mensen in het verkeer, en Google gelooft dat robotauto’s dat cijfer met negentig procent kunnen doen dalen. Maar wat gebeurt er als een ongeval tussen twee zelfrijdende auto’s onvermijdelijk is?

——————————————————————————————————–

|

// http://pagead2.googlesyndication.com/pagead/show_ads.js // http://pagead2.googlesyndication.com/pagead/show_ads.js |

——————————————————————————————————–

Aangezien het grootste deel van de auto-ongevallen te wijten is aan asociaal gedrag en menselijke fouten, lijkt er weinig twijfel over te bestaan dat zelfrijdende auto’s inderdaad veiliger zouden zijn. Robotauto’s houden zich aan de verkeersregels en kunnen obstakels sneller detecteren en ontwijken dan menselijke bestuurders. Bovendien zouden ze ook minder brandstof verbruiken en vlotter verkeer toelaten.

Maar zelfrijdende voertuigen verleggen ook ethische grenzen, met name in het geval er toch een ongeval dreigt — wat uiteraard altijd mogelijk blijft. Tom Chatfield vatte dat dilemma mooi samen in een artikel voor Aeon Magazine: “Wat doet je auto als er plots een school kinderen voor je wielen opduikt? Ontwijkt hij de kinderen, ook al brengt hij door dat manoeuvre jouw leven in gevaar? Of beslist de auto dat jij in de eerste plaats beschermd moet worden?”

De automatisering van de ethiek

Met andere woorden: zelfrijdende auto’s automatiseren de ethische beslissingen bij een ongeval. In de hierboven beschreven situatie zal nu elke chauffeur in een fractie van een seconde voor zichzelf bepalen of hij of zij rechtdoor rijdt of tegen een boom knalt. Maar in het geval van een zelfrijdende auto beslist de software daarover. Die software moet uiteraard door een mens worden geschreven. De vraag is dan: op basis van welke waarden?

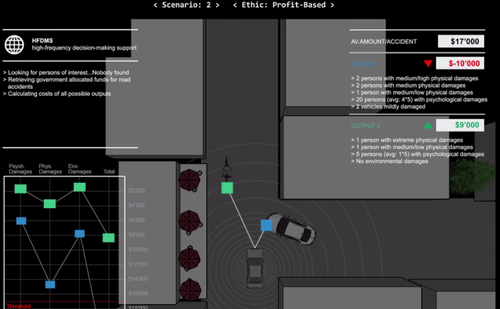

Matthieu Cherubini ging de uitdaging aan om een moreel systeem voor zelfrijdende auto’s te creëren. Hij ontwikkelde drie algoritmes waarmee de voertuigen in een situatie ethische beslissingen moeten nemen. Cherubini laat zien dat dezelfde situatie tot heel andere resultaten kan leiden alnaargelang het algoritme.

In het humanistische algoritme wordt gemikt op een zo laag mogelijk aantal slachtoffers, waarbij een auto kan beslissen om de inzittenden op te offeren om anderen te sparen. In het beschermende algoritme kiest de auto er steeds voor de eigen inzittenden te beschermen, ook al gaat dat ten koste van meer mensenlevens in het andere voertuig (of zwakke weggebruikers). En in het op kosten gebaseerde algoritme wordt er berekend welke uitkomst de maatschappij het minst kost.

De verschillende situaties zijn visueel voorgesteld in een video. Pittig detail: het eerste wat de software doet, is scannen of er zich in een van de voertuigen vooraanstaande personen bevinden.

Kris De Decker

——————————————————————————————————–

|

// http://pagead2.googlesyndication.com/pagead/show_ads.js |

Geef een reactie op Twanty Reactie annuleren